Zeka var mantık yok! ChatGPT bu soruların hala doğru yanıtlayamıyor: Yapay zekanın öncüsünden dikkat çeken açıklama

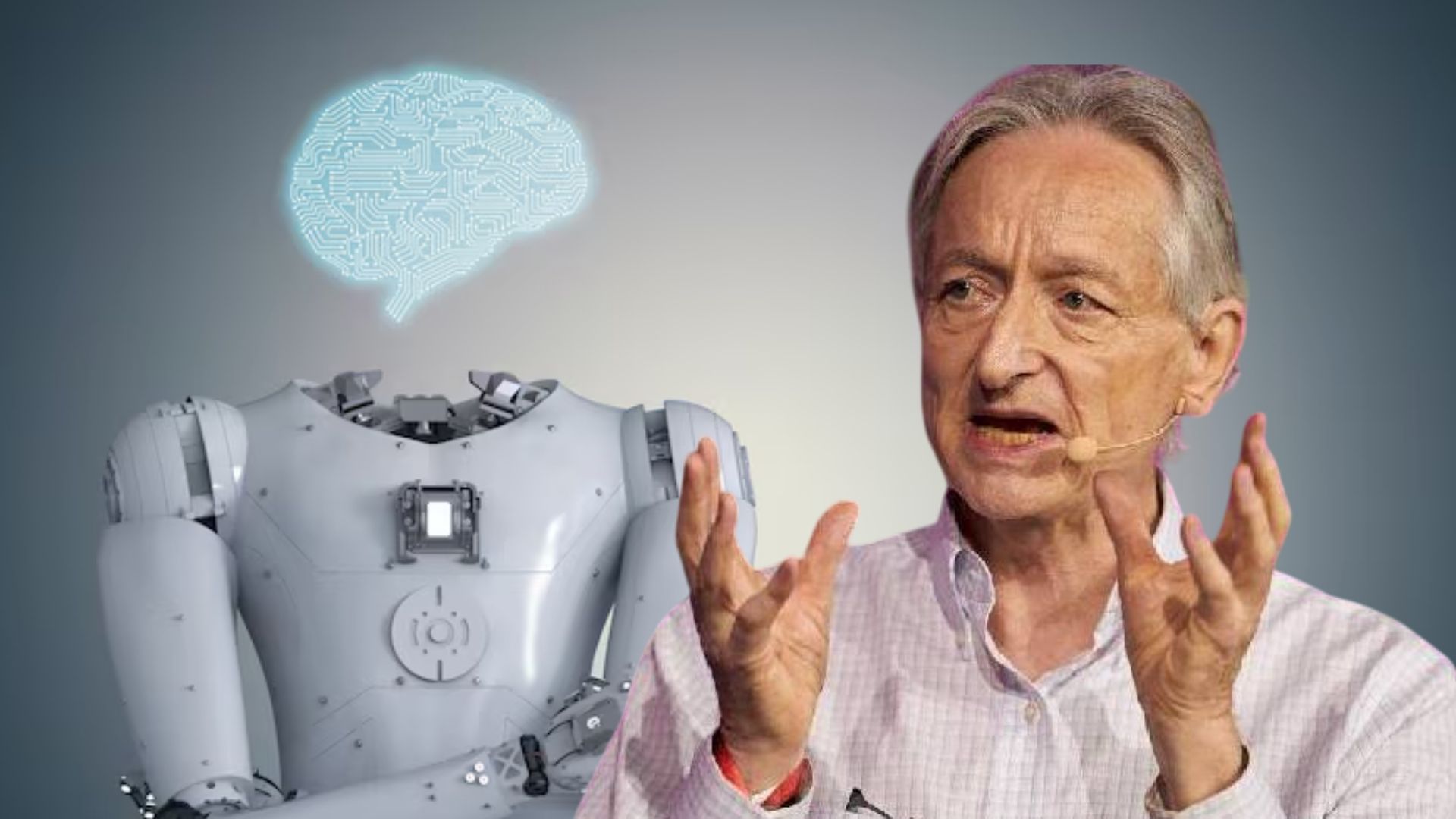

OpenAI tarafından geliştirilen en gelişmiş modellerden biri olan ChatGPT, karmaşık problemleri çözebilirken, kolay görünen bazı mantık bilmecelerinde şaşırtıcı hatalar yapıyor. Yapay zekanın gelişimine yön veren isimlerden biri olan Geoffrey Hinton, bu durumu eleştirerek "Hala bu sorularda hata yapmalarına şaşırıyorum" ifadelerini kullandı.

Yapay zekada zeka var ama mantık eksik

Yapay zekanın gelişiminde öncü isimlerden biri olan Geoffrey Hinton, OpenAI tarafından geliştirilen en ileri modellerden ChatGPT'nin temel mantık sorularında hala zorlandığını belirterek dikkat çekici bir uyarıda bulundu. Hinton, yapay zekanın son derece etkileyici başarılara imza atmasına rağmen, basit muhakeme yeteneklerinde önemli eksiklikler barındırdığını ifade etti.

Karmaşık işleri yapıyor ancak basit sorularda takılıyor

ChatGPT gibi gelişmiş yapay zeka sistemleri sınav sorularını çözebiliyor, yaratıcı metinler yazabiliyor hatta karmaşık yazılım kodları oluşturabiliyor. Ancak iş temel bir mantık sorusuna gelince, şaşırtıcı hatalar yapabiliyor. Hinton, yaptığı bir röportajda bu durumu çarpıcı bir örnekle ortaya koydu.

ChatGPT bilmeceyi hatalı cevapladı

Geoffrey Hinton, ChatGPT'ye şu basit bilmeceyi yöneltti:

"Sally'nin üç erkek kardeşi var. Erkek kardeşlerinin her birinin iki kız kardeşi var. Sally'nin kaç kız kardeşi var?"

Doğru cevap: Bir (Sally'nin kendisi ve bir kız kardeşi, üç erkek kardeşin her biri için iki kız kardeş eder). Ancak ChatGPT, soruya yanlış cevap verdi ve iki kız kardeş olduğunu belirtti. Bu küçük gibi görünen hata, aslında yapay zekanın temel mantıksal çıkarımlarda dahi zorlandığını gösteriyor.

Sadece veriden öğreniyor sezgi yok

Yapay zeka sistemleri devasa veri kümelerinden öğrenme yeteneğine sahip olsa da, insanlara özgü sezgisel anlayış ve sağduyudan yoksun. Bu da bağlam gerektiren veya dikkatli okuma gerektiren sorular karşısında sistemin yüzeysel kalmasına neden oluyor. Hinton, yapay zekanın bu nedenle bilge değil, yalnızca "verisel" olduğunu vurguluyor.

Aşırı güven tehlikeli olabilir

Hinton'un asıl uyarısı ise teknolojik araçlara duyulan aşırı güvenle ilgili. Yapay zeka sistemleri hata yapabilir ve bu hatalar özellikle eğitim, sağlık veya hukuk gibi alanlarda ciddi sonuçlar doğurabilir. Hinton, kendi ifadesiyle bazen ChatGPT'ye gereğinden fazla güvendiğini ama sistemin her zaman doğruyu söylemediğini bildiğini belirtiyor.

Geleceğe dair umutlu ama temkinli

Geoffrey Hinton, GPT-5 gibi yeni nesil modellerin bu tür mantık hatalarını azaltabileceğine inanıyor. Daha iyi bağlamsal anlama, daha sağlam mantık yürütme ve insana daha yakın bir muhakeme becerisi, yapay zekanın gelişiminde bir sonraki adım olabilir. Ancak tüm bu ilerlemelere rağmen, Hinton eleştirel yaklaşımın önemini vurguluyor: "Yapay zeka güçlü olabilir ama hala yanılmaz değil."

Sorgulayan insan aklı gerekli

Yapay zeka ne kadar gelişirse gelişsin, insan sezgisi ve sorgulayıcı düşünce biçiminin yerini tam anlamıyla alması şimdilik mümkün görünmüyor. Bu nedenle, teknolojiye olan güveni akılla ve dikkatle dengelemek, yapay zekayı bir araç olarak görmek büyük önem taşıyor.

(Fotoğraflar: Takvim Foto Arşiv, AA)